Sur l'exigence de contrôle des productions des IAg

from Quelques textes un peu trop longs pour mastodon (garanti 0% de matière IAsse)

Mlle Beaumaine, Théâtre des Variétés — about 1900 — Paul Nadar (French, 1856 – 1939)

Dans les recommandations habituelles qui fleurissent depuis quelque temps pour encadrer l'usage des IA génératives, on lit systématiquement quelque chose qui ressemble à : “ne faites jamais confiance à une IAg, contrôlez soigneusement avec d'autres sources”.

Faisons un détour par les systèmes critiques avant d'examiner les moyens de suivre ces recommandations. Nous ne traiterons pas ici de la question mais alors, pourquoi utiliser l'IAg ?, qui mériterait en soi un long développement.

Systèmes critiques : redondance de capteurs, identification des sources, probabilités de défaillance

Dans les systèmes embarqués critiques on assure la sûreté par de la redondance, en particulier la redondance matérielle des dispositifs qui permettent d'acquérir des informations sur l'environnement physique. Par exemple, si une fonction critique utilise les données d'un capteur (l'altitude ou la vitesse d'un avion, la température d'un processus chimique en cours, l'état d'un réacteur nucléaire...), il est de bon goût de prévoir au moins 2 capteurs (pas forcément du même modèle), au cas où l'un d'eux serait en panne. Un problème est détecté dès que les deux capteurs diffèrent suffisamment pendant suffisamment longtemps. Pour pouvoir déterminer quel capteur est en panne, on en met même plutôt 3, pour pouvoir voter, en faisant l'hypothèse que si deux capteurs donnent des valeurs cohérentes entre elles, mais différentes de la valeur du troisième, la probabilité est forte que le troisième soit défaillant. Parfois on met même 4 capteurs. Quoiqu'il en soit, la sûreté repose sur des sources d'informations redondantes, avec possibilité d'identifier la provenance des informations (capteur 1, capteur 2, ...) pour comparer. Par ailleurs la sûreté déclarée des systèmes qui utilisent ces capteurs repose sur une analyse des défaillances possibles. La probabilité qu'un capteur tombe en panne est trop grande pour qu'on fasse dépendre la sûreté de tout le système de cette unique source d'information. La probabilité de deux pannes simultanées est déjà plus faible, pour 4 pannes simultanées on considère que la probabilité est tombée suffisamment bas pour que le risque (qui n'est jamais nul) soit tolérable.

Comment contrôler la production des IA génératives ?

Cette analogie permet-elle de comprendre comment appliquer la recommandation “ne faites jamais confiance à une IA, contrôlez soigneusement avec d'autres sources” ? Imaginons une situation où la production de l'IAg va servir dans un processus de décision important, par exemple. Comment contrôler ? Sommes-nous vraiment dans la situation de la redondance de sources d'information, avec identification de la provenance et estimation des probabilités de défaillances simultanées ?

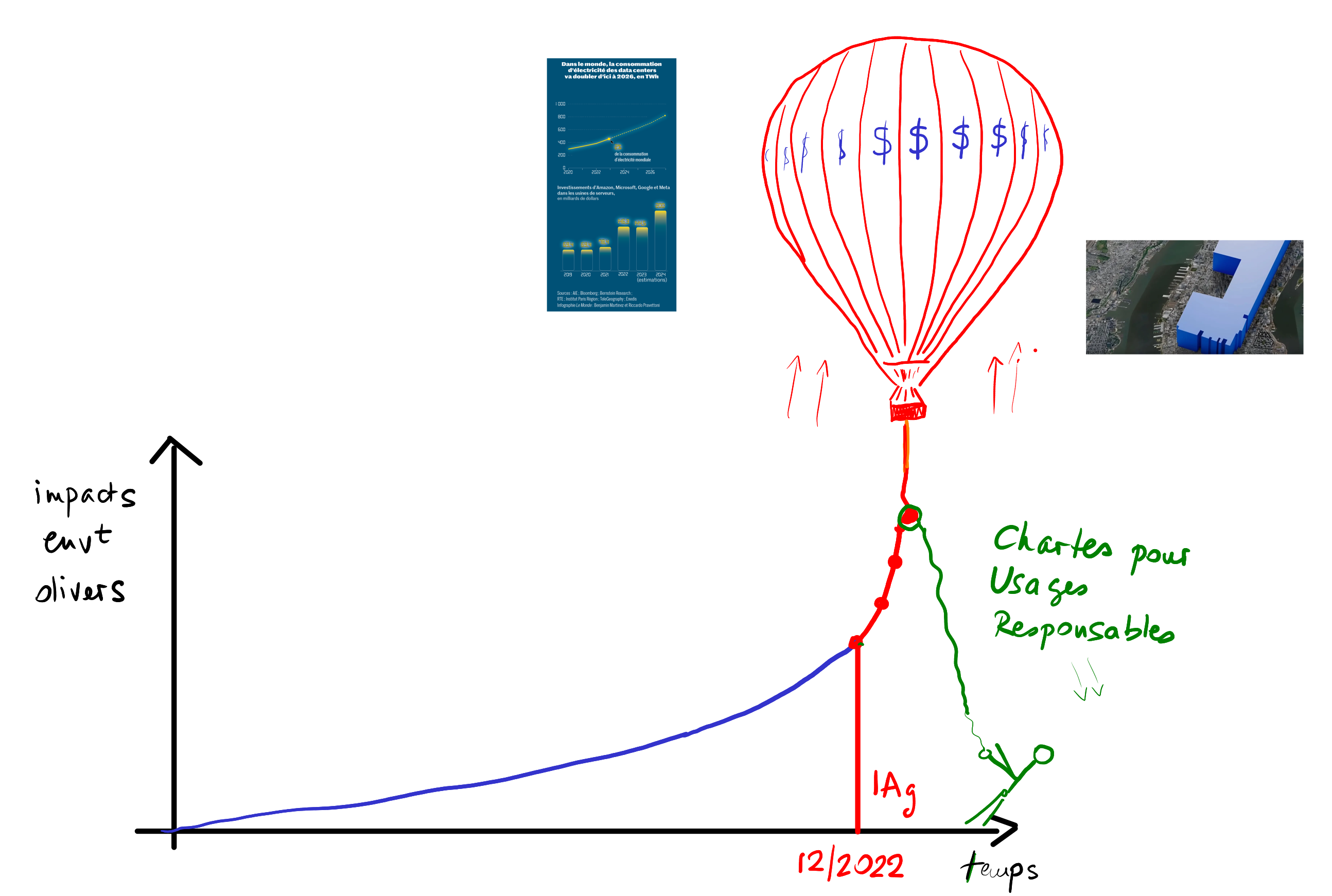

Si on fait une photo de l'état actuel de l'information en ligne — ou peut-être qu'il aurait fallu faire cela il y a 3 ans — on peut encore se convaincre que les productions des IA génératives peuvent être confrontées à ce qu'on trouve dans un espace informationnel non pollué, et que l'identification de provenance est encore possible.

Mais les productions des IA génératives et les informations authentiques cohabitent dans un même espace. Avec cet effet de pollution informationnelle à grande échelle engendré par un usage répandu et inconsidéré des IA génératives elles-mêmes, comment la situation évolue-t-elle ? va-t-on pouvoir encore distinguer l'authentique du généré, pour continuer à “contrôler” les productions des IAg ? Tout porte à croire que la redondance et la connaissance des sources, indispensables à la garantie de qualité de l'information sur laquelle on se base pour la suite du travail, sont menacées.

Comment contrôler ce que dit une IA générative sur un sujet, si les moteurs de recherche fournissent également des résumés faits par des IAg, qui plus est de sources elles-mêmes générées par IA ? On s'inquiète parfois de dégradation intrinsèque de la qualité due au fait que les IAg se nourrissent des productions d'autres IAg. Mais le risque principal pour l'utilisateur est de ne plus pouvoir distinguer les sources, et d'être donc dans l'incapacité d'appliquer la fameuse injonction de contrôler les productions des IAg.

#resistIAGen

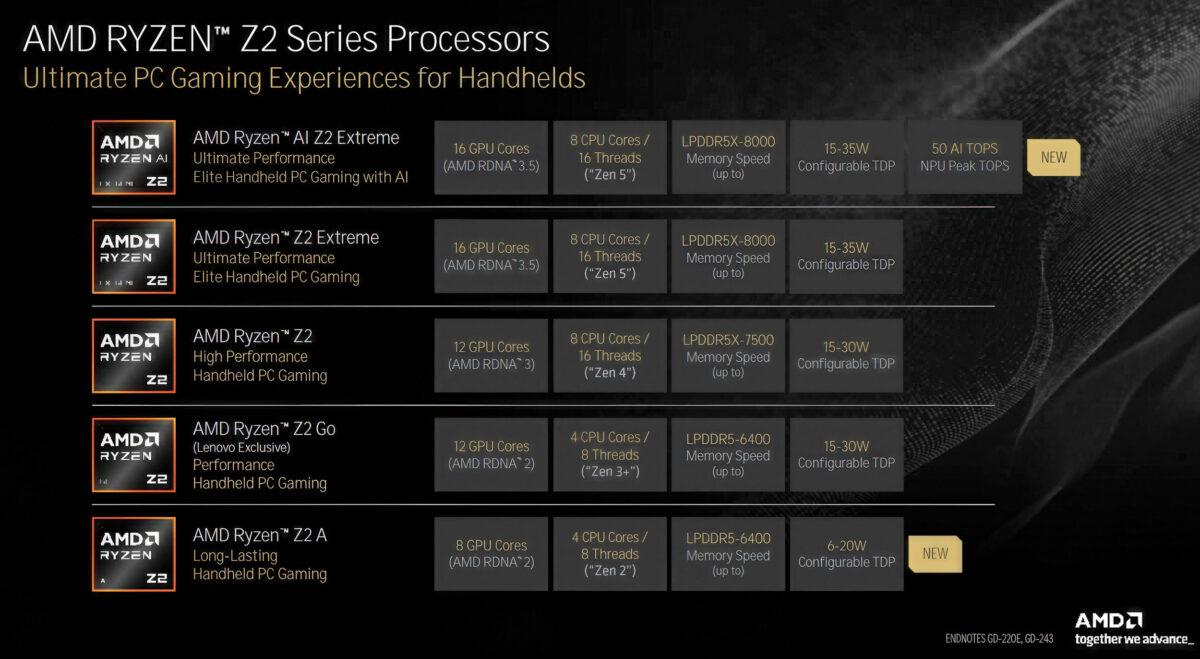

Par exemple la Zotac Gaming, avec une config inférieure (RDNA 3, 16Go RAM) est à

Par exemple la Zotac Gaming, avec une config inférieure (RDNA 3, 16Go RAM) est à

L'OS semble démarrer directement avec une nouvelle interface “gaming” permettant d'intégrer tous les stores et launchers. Il y a la possibilité de démarrer en mode “Windows” mais la présentation ne nous a pas permis d'en voir plus.

L'OS semble démarrer directement avec une nouvelle interface “gaming” permettant d'intégrer tous les stores et launchers. Il y a la possibilité de démarrer en mode “Windows” mais la présentation ne nous a pas permis d'en voir plus. Ah oui, et c'est moins puissant qu'une Switch 2 (équivalent à une RTX 3060)... La comparaison va faire très mal à la marque Xbox...

Ah oui, et c'est moins puissant qu'une Switch 2 (équivalent à une RTX 3060)... La comparaison va faire très mal à la marque Xbox...